Stable DiffusionというAIソフトで塗りを手伝ってもらったので方法をご紹介します。

はじめに

この度、ガールズ&パンツァーのゴモヨちゃんを描いてAIに塗りを手伝って貰いました。

左から「手書きで線画」→「AIで着色」→「手書きで修正して完了」って感じです。

今回の記事はそれのやり方について説明したいと思います。

ちなみに「AIで着色」ですが、かなり失敗作が出てきます。

今回は800枚ぐらい出力し選んだのがこの子です。

選び抜いた子ですが、それでも服が透けてたり目が死んだりしてましたので、その後手で修正をしました。

私の線画と設定が下手というのもありますが、AIはまだ万能じゃないと思います。

もう少し上達したら一発で良い感じに出力できるようになるかもしれませんが、今回は「大量出力してその中から選んで手修正する」という方法を説明させて頂きます。

線画を作成する。

これはいつも通りですね。私はクリップスタジオで作成しました。

(さくっと紹介してるけど、この線画を描くのに1時間近くかかってますw)

Stable DiffusionというAIソフトで着色する。

着色の前にソフトの説明をします。

Stable Diffusionというソフトを使います。非常に有名なAI画像生成ソフトですね。

本来は出力がメインみたいですが、ControlNetというプラグインを入れる事で塗りも出来ます。

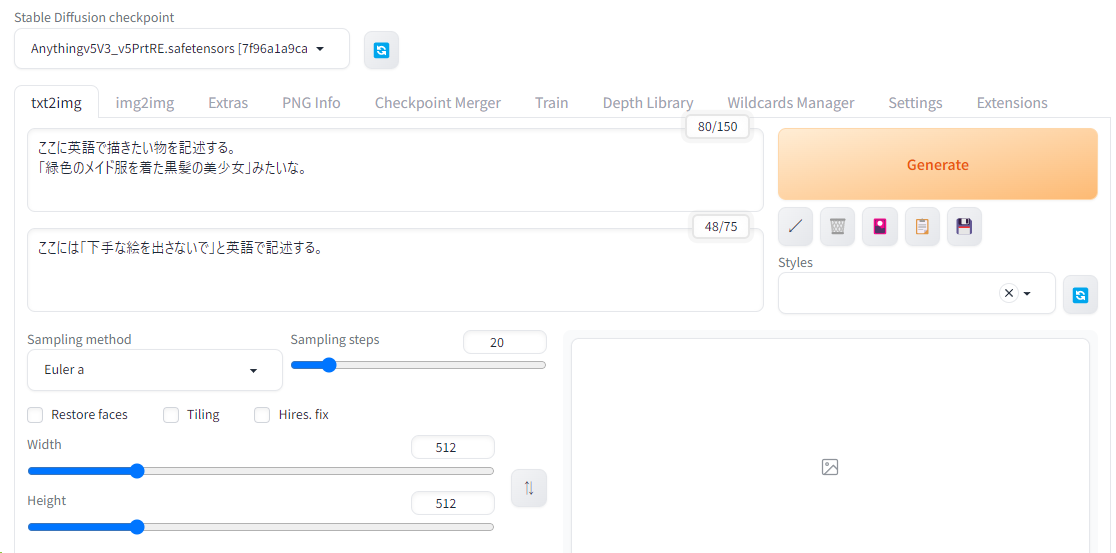

ソフトの雰囲気は↓みたいな感じです。ローカルサーバ起動させてブラウザで動くタイプですね。

詳しいインストールの方法や設定方法は専門家の動画やブログを見て下さい。

ちなみにこのツール、マシンパワーをめちゃくちゃ使います。マシンが弱いと超遅いです。

私が以前使っていたPCのグラフィックボードだと1枚の出力に20秒ぐらいかかりました。

2023年5月にちょうど買い替えて強いPCにしたのですが、それだと1枚1~2秒ぐらいで出力されます。グラフィックボードの性能差で大きく変わるようです。

今回私が購入したのがコレです。こんな高いの買ったこと無いですよ。泡拭きますね。7年は使いたいです。デカすぎてケースごと買い替えました(泣)

(PCスペックの詳細は「【Ryzen 9 7950X3D+GTX4090】強いPCを自作しました。強いPCを自作しました。」って記事に記述しました。)

ちなみに前回まで使ってたのは↓の1060ってやつです。当時は3DのゲームがPCで動いて感動した覚えがあるんですけどねぇ。とりあえずコレでも出力はできました。

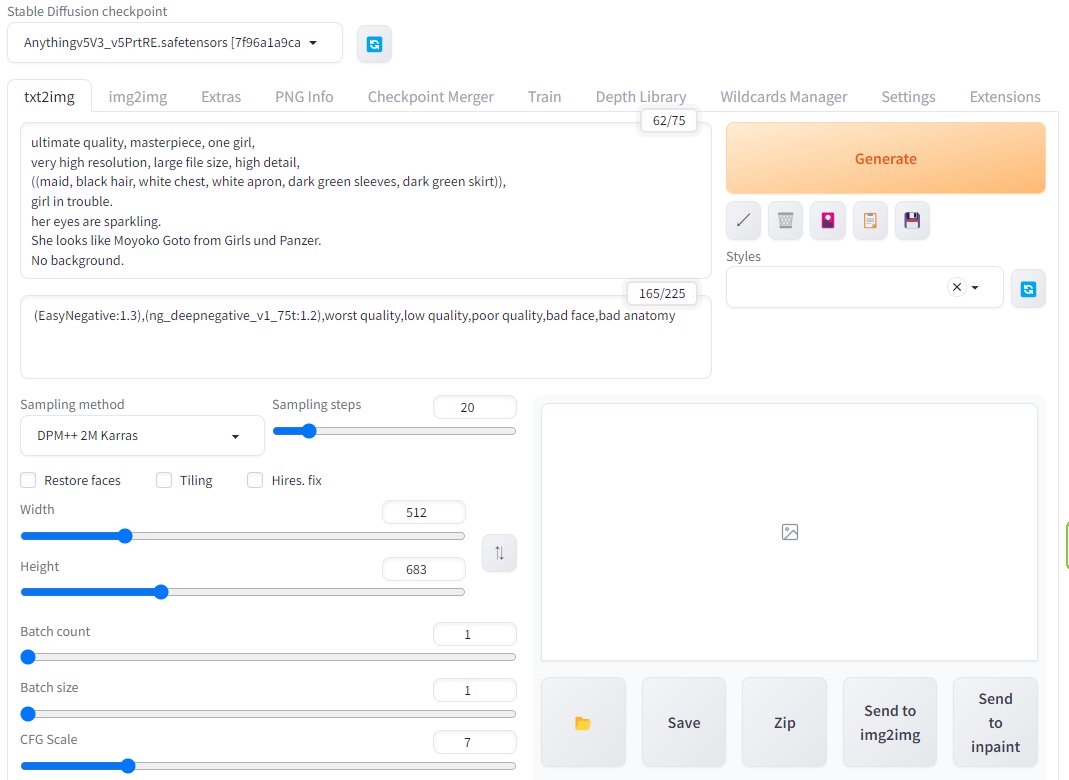

Stable Diffusionで着色処理の設定をする。

では設定をしていきますよ。

↓の画像が低画質ですみません。詳細は後述してますので雰囲気だけ感じて下さい。

・出力モデル

→「anythingv5v3」を選択。他にもあるみたいですけど、とりあえずコレを選びました。

塗りだけなら関係ないかもしれませんが、何かしら選択しないとダメっぽいです。

・プロンプト(出力したい画像の設定)

→下記を英訳した物を貼り付け。

非常に高い解像度、大きなファイルサイズ、高詳細、

((メイド、黒髪、胸元は白、エプロンは白、深緑色の袖、深緑色のスカート))、

困っている女の子。

目はキラキラしている。

ガールズ&パンツァーの後藤モヨ子ちゃんみたいな子。

背景は無し。

ガルパンのくだりは要らないと思いますが、私には大切な事なのですw

()で囲むとAIは「重要」と認識してくれるようです。これがないと金髪になったりします。

また笑顔になったり目が死んでる事があったので「困ってる」や「目がキラキラ」を指定しました。

・ネガティブプロンプト(出力したくない画像の設定)

→下記を貼り付け。

動画サイトを参考にプラグインを入れてました。「変なの出すな」的な意味らしいです。

・Sampling method

→「DPM++ 2M Karras」を選択。

あまり深い意味は分かりません。塗りだけなので選ばなくても良いのかもです。

・Height

→縦の長さを「683」に設定。

画像が縦長ですからね。もっと長くても良いかもですが、とりあえず4:3にしました。

・ControlNet v1.1.146

→線画を読み込ませるプラグインです。塗りのメイン機能ですね。ここは設定が多いです。

①線画をD&Dで読み込ませる。

②Enable:チェックを入れる。

(これを入れないと線画を読み込まない)

③Allow Preview:チェックを入れる。

(これを入れないと線画の白い箇所に着色しない。AIは「黒い箇所」に着色するらしいです。)

④Preprocessor:lineart_anime

(cannyとかもあるみたいですが、とりあえずコレにしました)

⑤Model:control_v11p_sd15s2_lineart_anime [3825e83e]

(とりあえずコレにしました。違うのでも良いと思います。)

⑥PreprocessorとModelの間にある「★」的なマークをクリックする。

→これで線画の白黒反転版が作られます。

これで「黒い箇所」に着色してくれるようです。

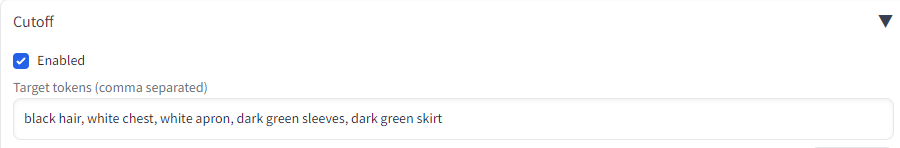

・Cutoff

→着色を細かく指定するプラグインです。役に立つか分かりませんがやってます。

①Enable:チェックを入れる。

②下記を英訳した物を貼り付け。

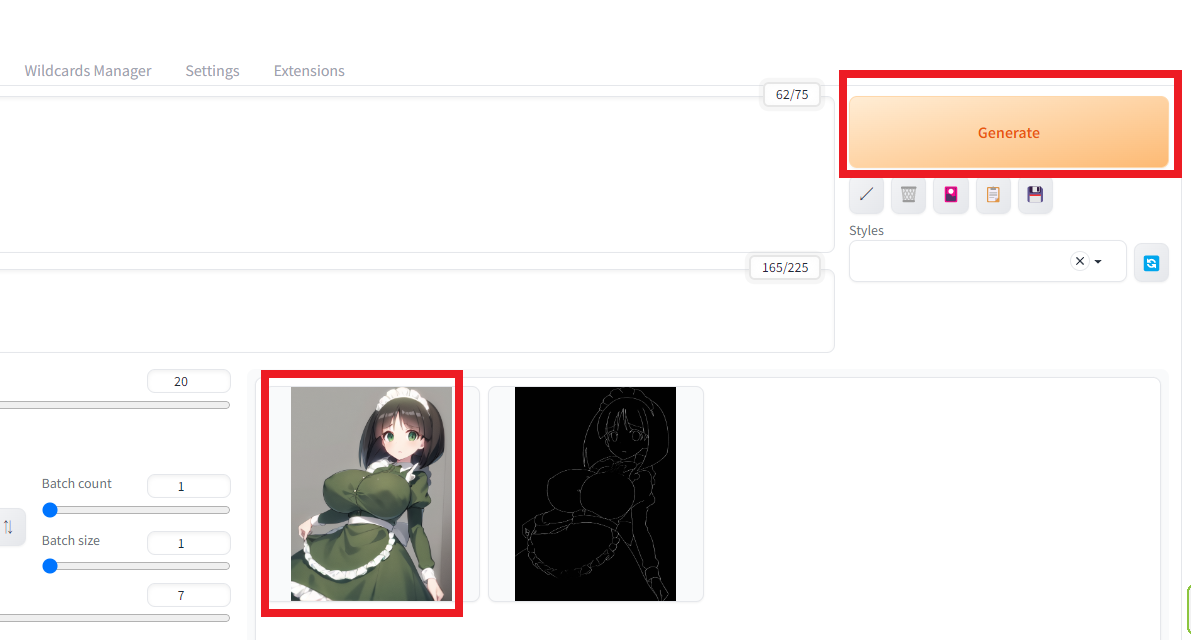

テスト出力をする。

上記の設定が完了したら「Generate(ジェネレート)」ボタンを押して下さい。

すると着色された画像が出てきます。

(やっと)想定に近い物が出てきました!

この時に設定がおかしいと線画と関係ない画像が出てきたり、金髪だったり黒服だったり、背景が海や森だったりします。

想定に近い物が出るまで何度も設定やプロンプトを変えて、想定に近い画像が出るまで繰り返して下さい。

大量出力をする。

テスト出力が終わったので、大量出力します。

今回は100回連続×8マスで出力します。(PCの性能により速度は大きく変わります。以前のPCだと4時間ぐらいかかりました)

今回の設定ですとこのように8マスずつpngファイルが出力されます。

ご覧の通り、髪の色が変だったり、半袖だったり、エプロンの色が緑色だったり、背景があったりいろんなのが出てきます。

出力された中から理想に近い子を探す。

出力が終わったら出力先フォルダにアクセスし、山ほどあるpngファイルの中から理想に近い画像を探します。

これが意外と面倒です。

「あれ、この子良いかなー?」と思ったらフリルが塗られていたり、背景(※)があったり、変な影がついてたりします。

※ゴモヨちゃんの場合、襟元が勝手に塗られてたりするので手直しは必須です。なので背景があると困るのです。

そして最終的に選ばれた子がこの子です。

目にハイライトが無かったり、胸が透けてましたが良しとします。後で手直ししますので。

クリップスタジオなどで出力された画像を加工します。

①元のpngだとサイズが小さい(683×512)ので「waifu2x」などで大きくします。

②クリップスタジオでpngファイルを開きます。

③背景を全て削除して透明化します。

④目のハイライトや透けた胸元などを修正します。

⑤背景を入れます。

これで完成です!お疲れ様でした!

最後に感想です。

AIはやっぱり便利ですね。

私みたいな「塗りが難しい、陰影どう描けば良いんだ・・・うん、やり直し!最初から!」って人には非常に助かるツールだと思います。

今の所、最終的にはやっぱり手修正が必要になりますが、それでも十分助かりますね。

今後はAIと手動をパートにより使い分けながら描くんじゃないかなーと思います。

気分次第で全部手動で塗りとかやるとは思いますが。

このツールもレイヤー分けなどもしっかりできるようになったらもっと化けるんじゃないかなーと思います。(レイヤー分けできそうなツールがあるんですが使ってみてイマイチでした)

こういうAIツールは非常に便利なので、今後も正しい使われ方をして伸びていってもらいたいですね。

コメント